こんにちは、うにです!

うにはVtuberだと周央サンゴさんと壱百満天原サロメさんが好きなのですが、

Vtuberのフェイストラッキングやリップシンクってどうやってるんだろう?と思いませんか?

ということで本記事では、無料ソフトVSeeFaceとvrmモデルで、Vtuberみたいなリアルタイムフェイストラッキングを試してみます。

ノートPC1台でとっても手軽にできて面白いです。

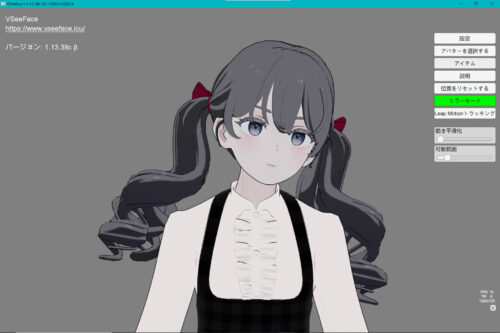

自分の動きやまばたきも反映して、こんな感じの画面がとれるようになります↓

音声、字幕をつければそのままショート動画が作れちゃいますね!

という方の参考にしていただけますと幸いです。

VSeeFaceでVtuber的フェイストラッキングを実現するまで

全体像としては、以下のステップでVtuberのような動画が収録できるようになります。

1.PCにVSeeFaceをインストールし、アバターをアップロード

2.VSeeFaceで各種フェイストラッキング設定

3.動画用音声を準備 (地声もしくは音声生成ソフト等で録音)

4.PCにOBSをインストールし、VSeeFaceと連携

5.OBSで収録しながら、VSeeFaceで3の音声を読み込んで再生

本記事では上記手順1、2の「VSeeFaceでアバターを動かし、カメラからリアルタイムのフェイストラッキングを実施できるようにする」ところまでの手順をご紹介します。

VSeeFaceでフェイストラッキング:準備するもの

うにの環境と、用意したものは以下の通り。

・ノートPC:Microsoft surface laptop4

・動かしたいアバター(.vrm形式)

フェイストラッキングにはノートPCのインカメを、

リップシンク用の音声入力はノートPCの内蔵マイクを使うこととします。

あとは動かしたいアバターをvrm形式で準備しておきましょう。

表情を動かしたりリップシンクを行いたい場合は、それらに対応するパラメータ(ブレンドシェイプ)がvrmモデルに設定されている必要があります。

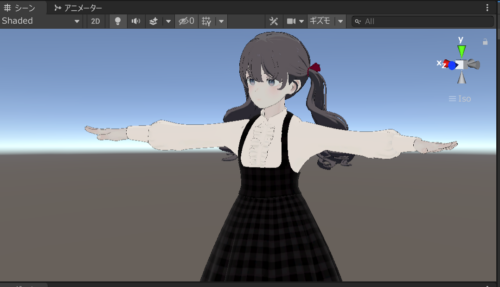

うにの場合はおなじみのGrusちゃんにvrm版も同梱されていたので、こちらをそのまま使用できました。

せっかくなのでunityで、vrmモデルにも改変を反映しておきます。

改変に使用している衣装などはこちらの記事にまとめています↓

vrmモデル+ChatGPTでおしゃべりAIもつくれます↓

無料フェイストラッキングソフトVSeeFaceのインストール

VSeeFaceを使用するために、まずはPCにソフトウェアをインストールします。

公式ウェブサイトから最新バージョンをダウンロードします。

ダウンロードができたらzipファイルを解凍し、

VSeeFaceのフォルダ内にある「VSeeFace.exe」から起動します。

VSeeFaceで実際にフェイストラッキングをしてみる

VSeeFaceの起動

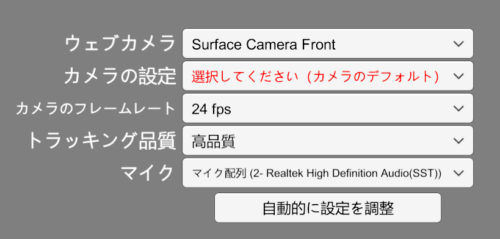

VSeeFaceを起動したら、まず設定画面が開くので、カメラ・メイクなどの設定を行います。

初回は「アバターの追加」からvrmデータを登録します。

アバター一覧から使いたいアバターを選択して「スタート」を押します。

最低限やることはたったこれだけ!

体を揺らしたり、まばたきをしたり、声を発すると画面内のアバターが連動して動くことを確認できます。

動かないときはカメラ、マイクの入力が正しく設定されているか確認しましょう。

画面ズームや視点移動などの操作

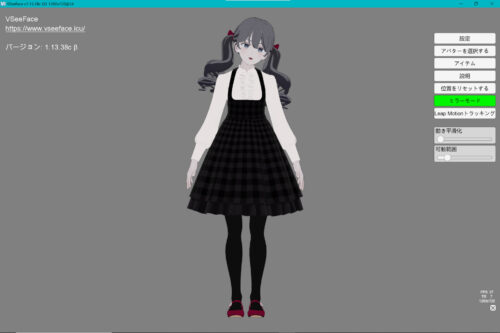

初期状態では顔のアップを正面から移すアングルになっていますが、

全身を映したり、違う角度からのアングルに変更することが可能です。

ただしこのソフトはカメラで取得している表情を追従するものですので、トラッキングできるのは首から上だけ。

専用のハード「Leap Motion」を連携しないと手から下は動きません。

(高価なので、ハンドトラッキングも含めたい場合は別の方法を検討するかな…という感触です)

全身を画面に映しても棒立ちになってしまうので、VSeeFaceを使用するならバストアップくらいのアングルが使いやすいと思います。

体の動きをトラッキングしたいときは、ThreeDPoseTrackerという無料ソフトが手軽です♪

各種パラメータを設定

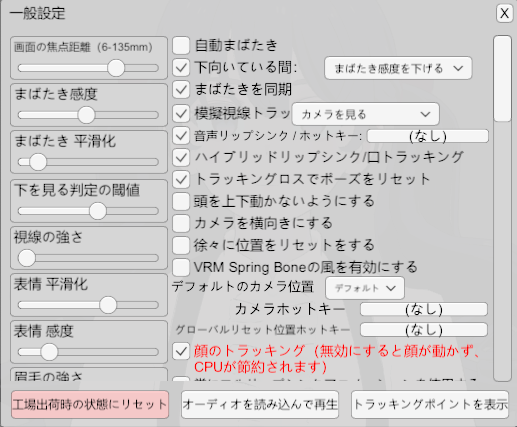

VSeeFaceはカスタマイズが豊富です。

設定>一般設定 からまばたき感度、可動域など自分の好みに合わせて設定を調整できます。

初期設定でおおよそ問題なく動きますが、もし部位ごとに違和感を感じるところがあればパラメータを調節しておきましょう。

たくさんあって理解しきれていないのですが、体感でざっくりいうと

「平滑化」が大きい、「感度」が小さい→動きが安定するがレスポンスが鈍くなる

「平滑化」が小さい、「感度」が大きい→動きが安定しないがレスポンスが良くなる

という感じで調整しています。

表情の検出方法を設定

同じく設定>一般設定 から表情の設定ができます。

「トラッキングポイントを表示」をONにしておくと、実際の表情がどうトラッキングされているのかを確認することができます。(以下の画像左に表示されている緑の顔がそれです)

表情の検出方法には3種類の方法があります。

1<2<3 の順で、実際の表情とアバターの表情の同期度合いが高くなります。

表情の自動検出のうち、2.「シンプル」は自分の表情に合わせて、「Fun」「Angry」「Surprised」のみを反映してくれるモード。

軸正(キャリブレーション)は不要、設定が手軽で精度も良いです。

3.「実験的な表情検出」は上記の「シンプル」に加えて、「Joy」「Sorrow」「Surprised」などの表現もできるモード。

こちらを選択すると画像のような軸正(キャリブレーション)用ボタンが出てきます。

それぞれに対応する表情を記録して軸正を行う手間はありますが、より自然な表情の同期が可能になります。

まとめ

本記事では無料ソフトVSeeFaceを使って、Vtuberみたいなリアルタイムフェイストラッキングを試してみました。

多機能なのに直感的に操作できるところが素晴らしく、想像していたより100倍簡単に想像通りのことが実現できて感動しました!

「youtuberデビューしたいけど実写は抵抗あるなあ…」という方は、こういったツールを使ってVtuberに挑戦してみてはいかがでしょうか?

この記事が、VSeeFaceを使ったフェイストラッキングに興味がある方の参考になりますと幸いです。

最後までお読みいただき、ありがとうございました♪